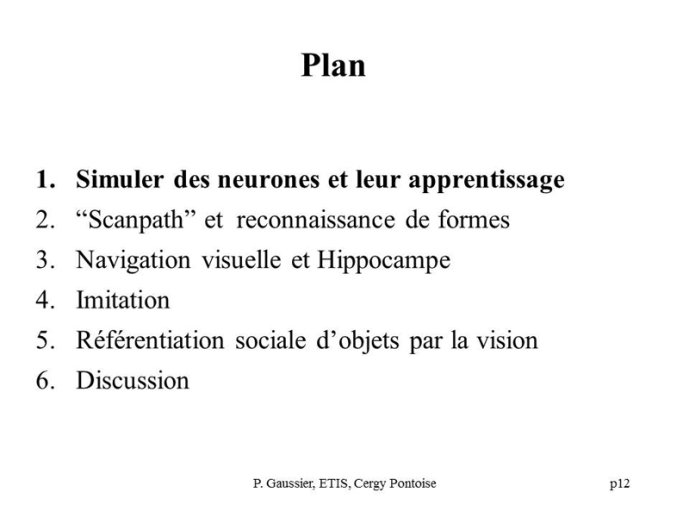

Chapitres

- Préambule12'59"

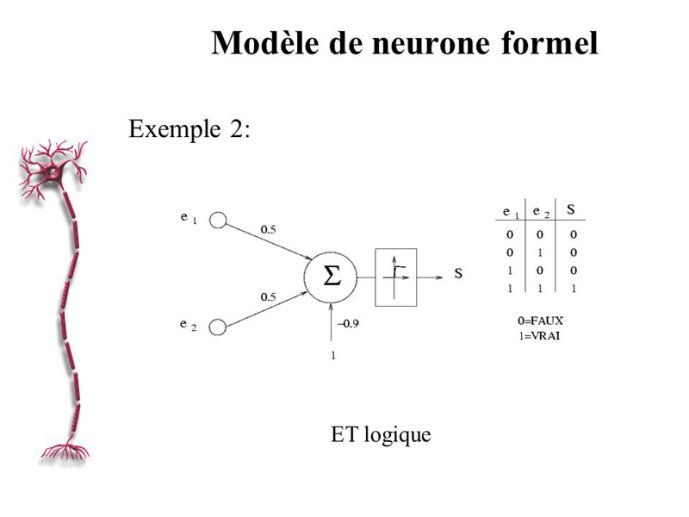

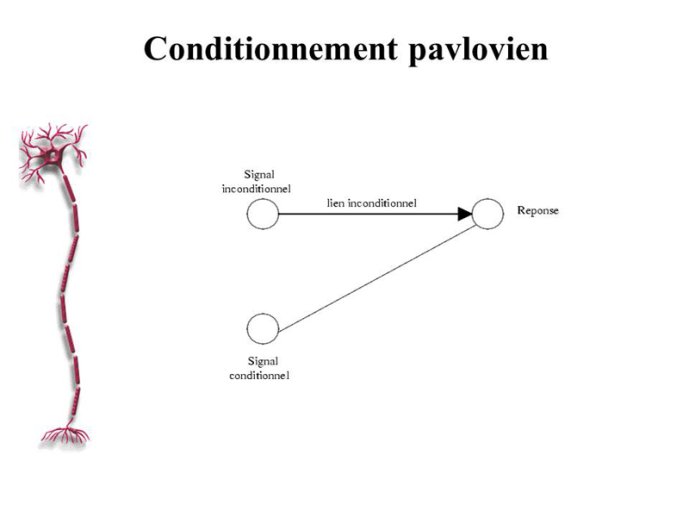

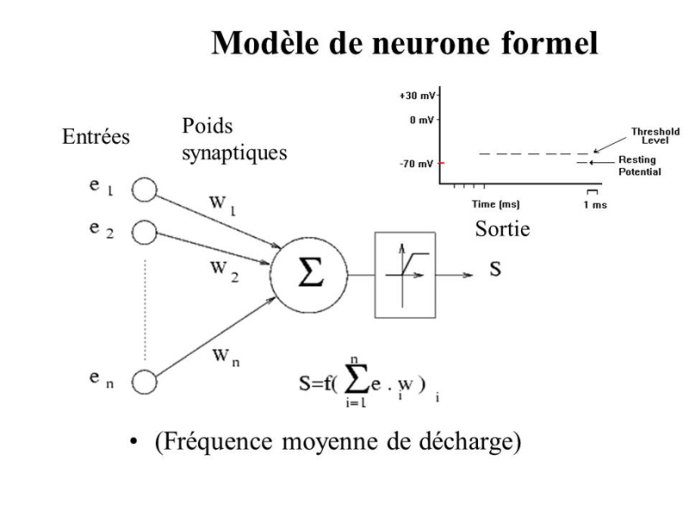

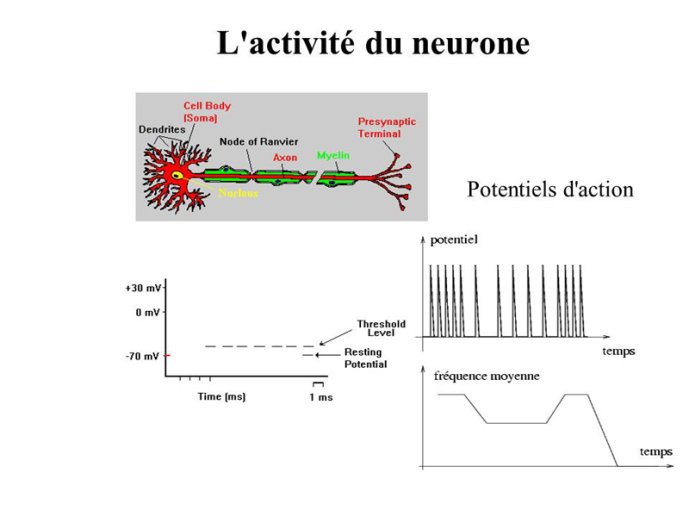

- Simuler des neurones04'55"

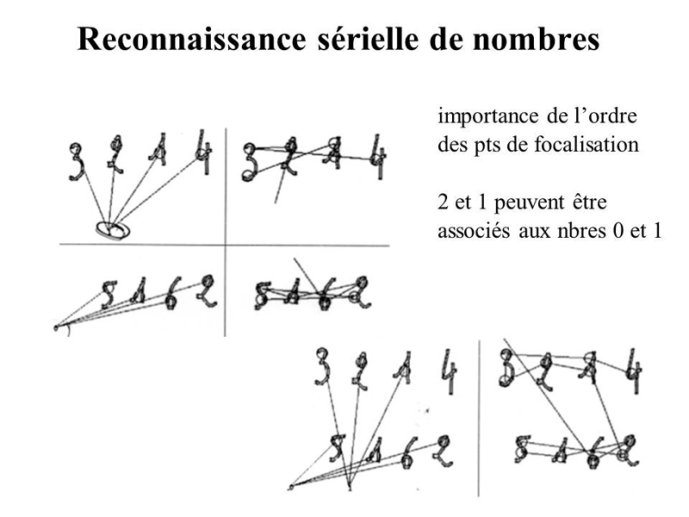

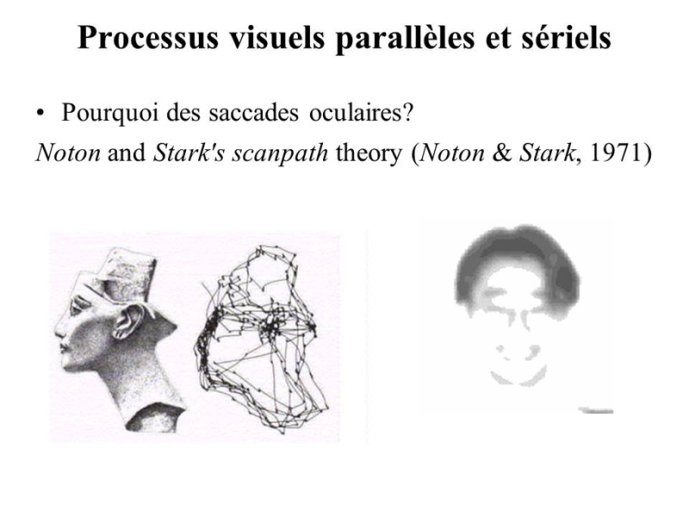

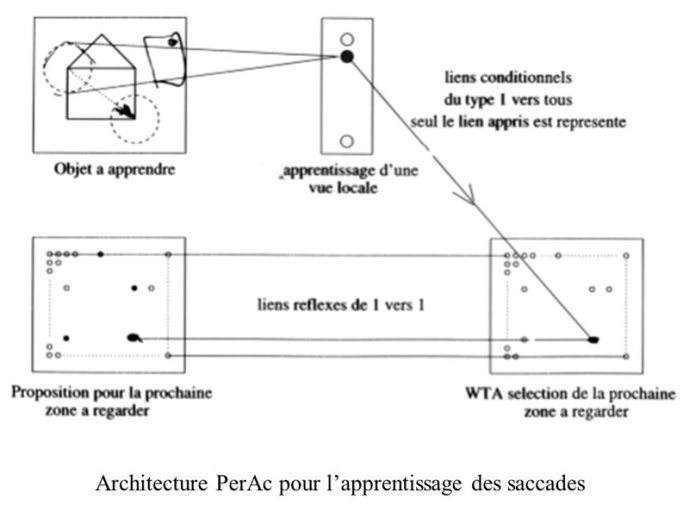

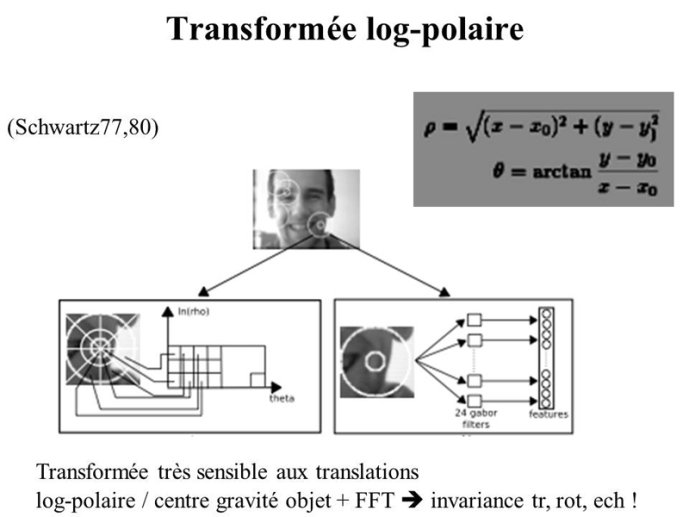

- Scanpath20'15"

- Imitation12'50"

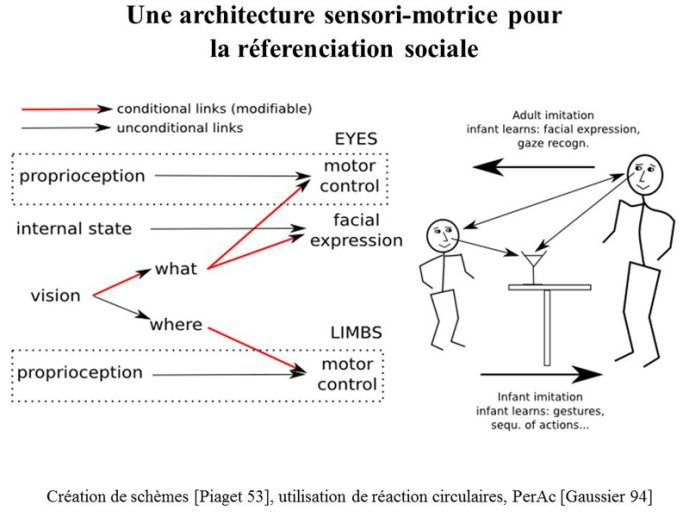

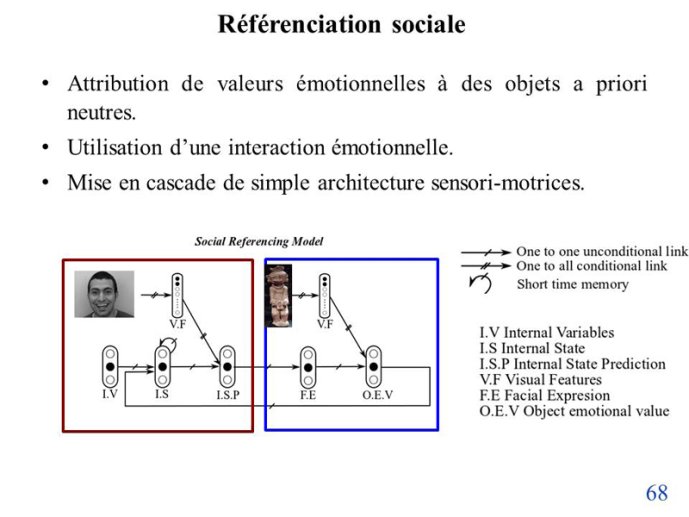

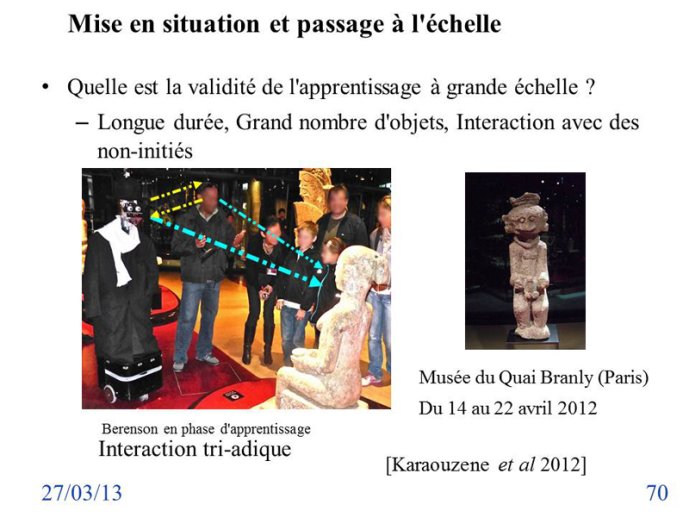

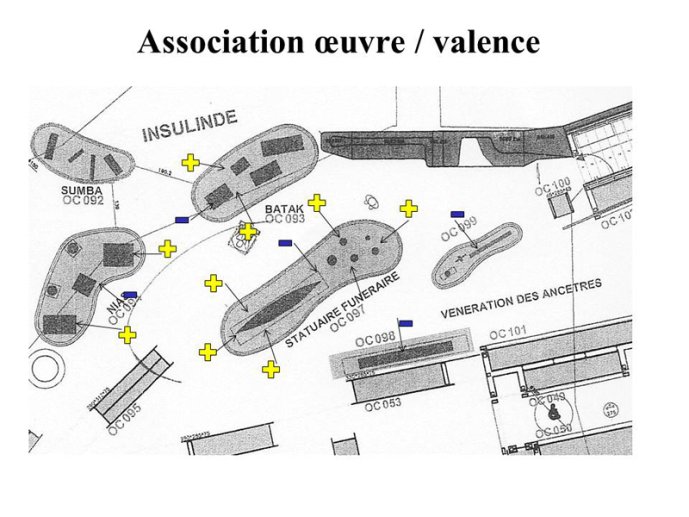

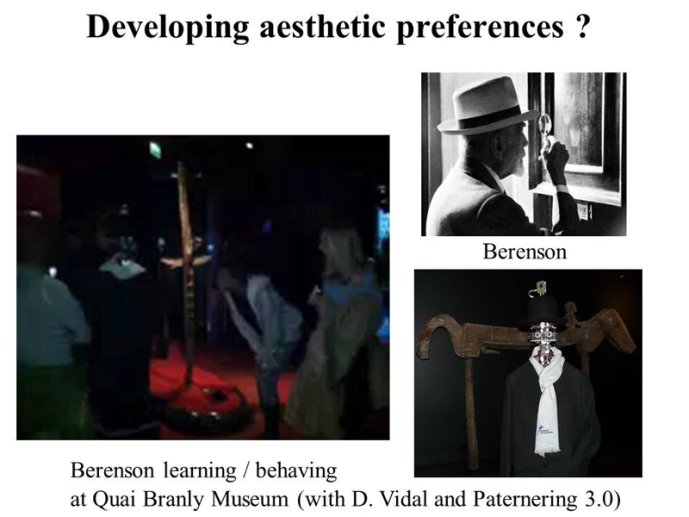

- Référentiation sociale07'57"

- Discussion04'37"

- Questions / Réponses15'16"

Notice

2013 - Vision et regard - Du regard à l'interaction : l'apport de la robotique développementale

- document 1 document 2 document 3

- niveau 1 niveau 2 niveau 3

Descriptif

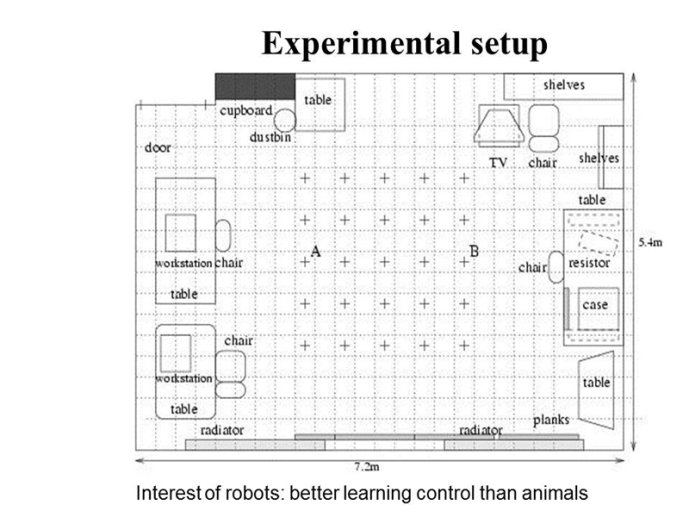

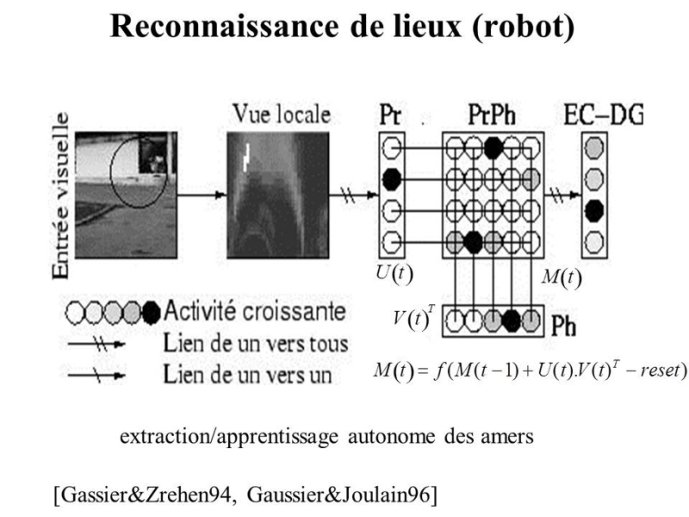

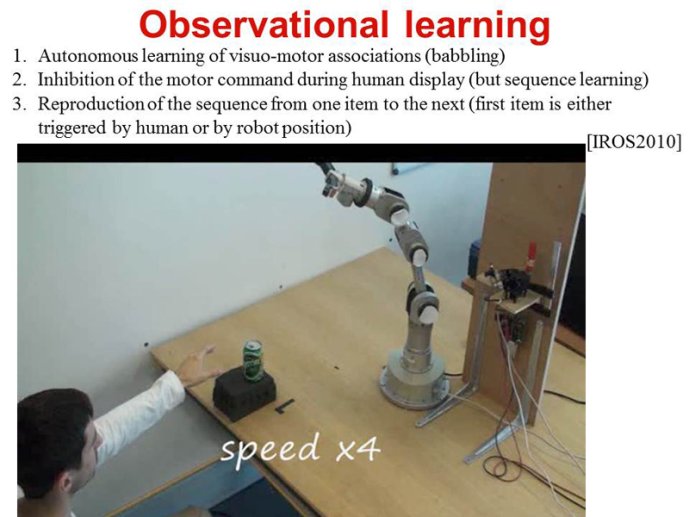

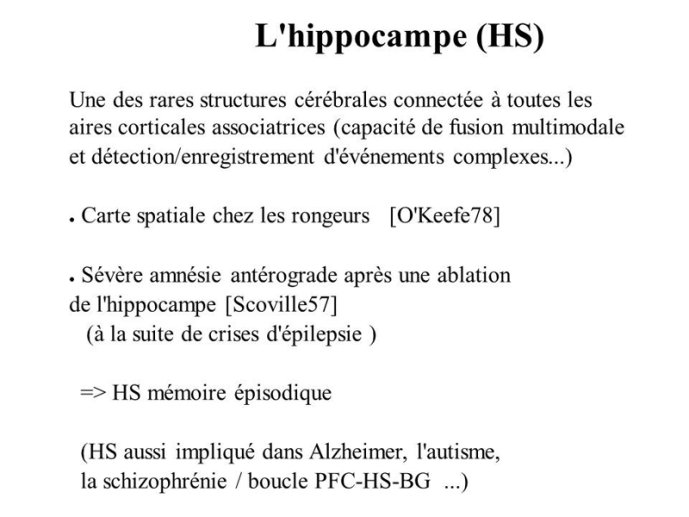

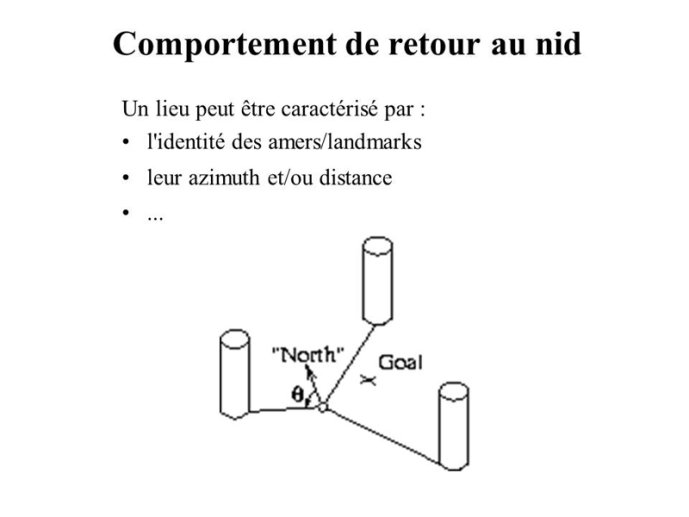

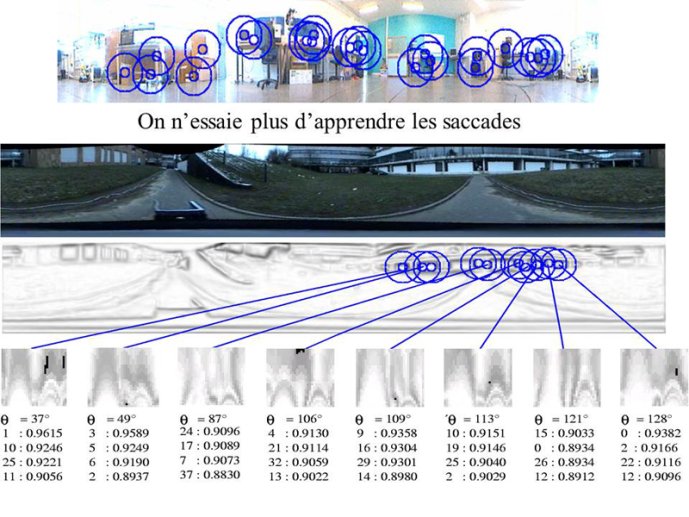

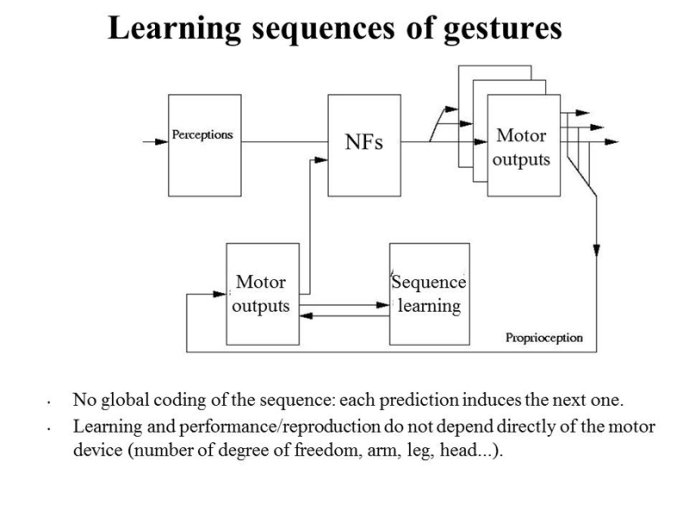

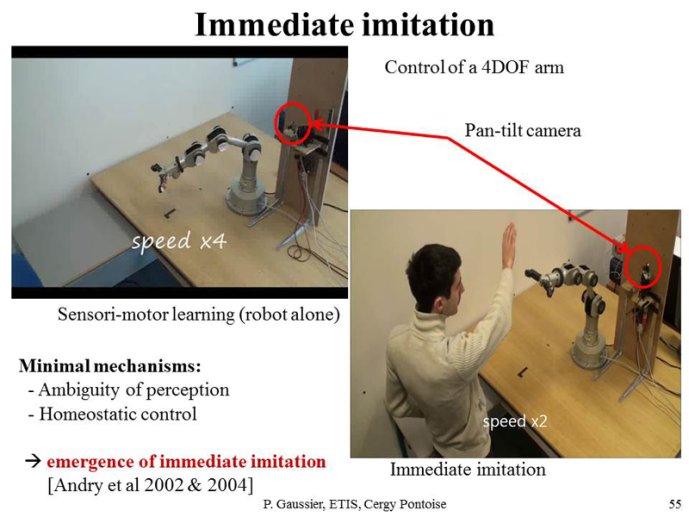

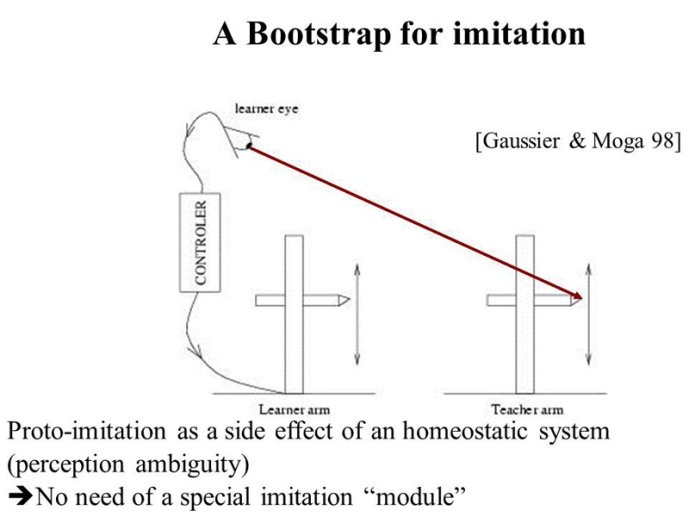

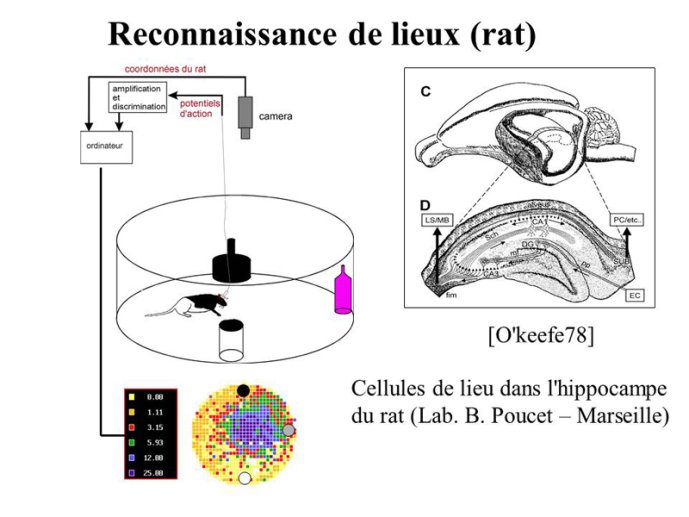

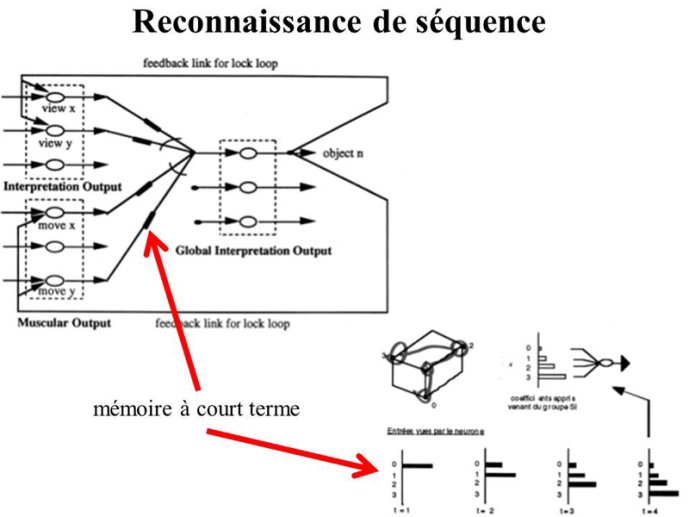

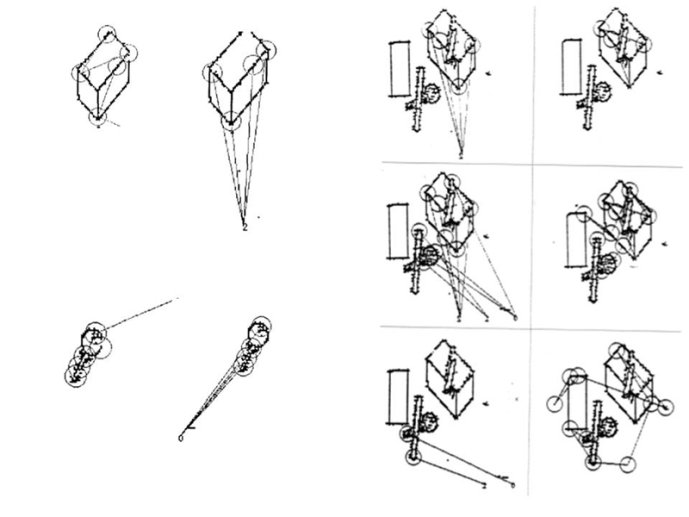

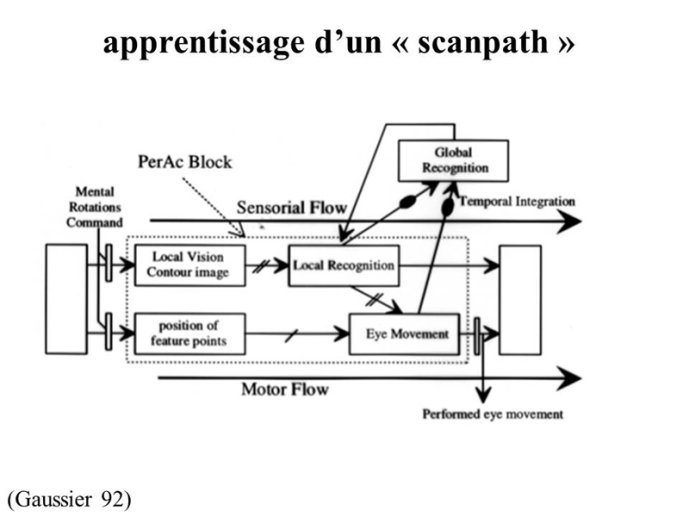

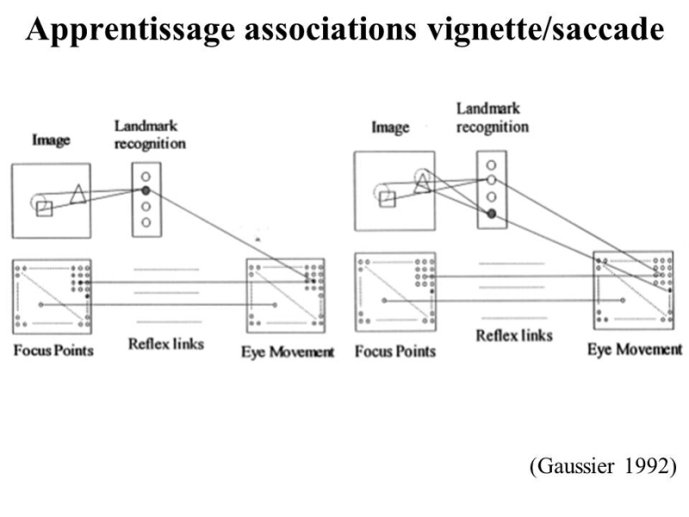

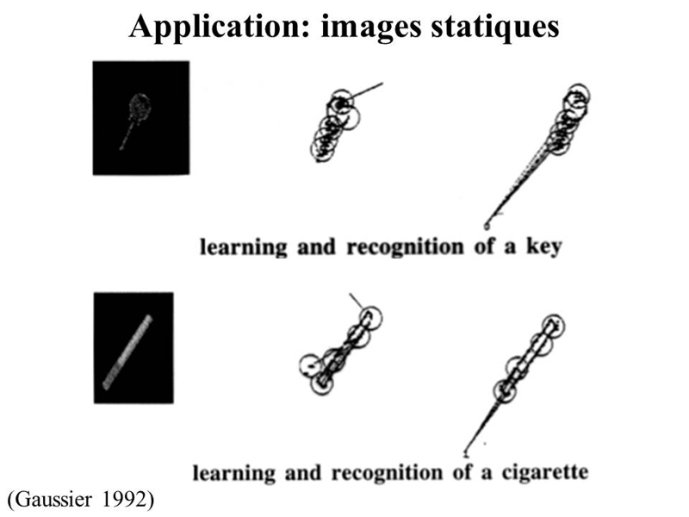

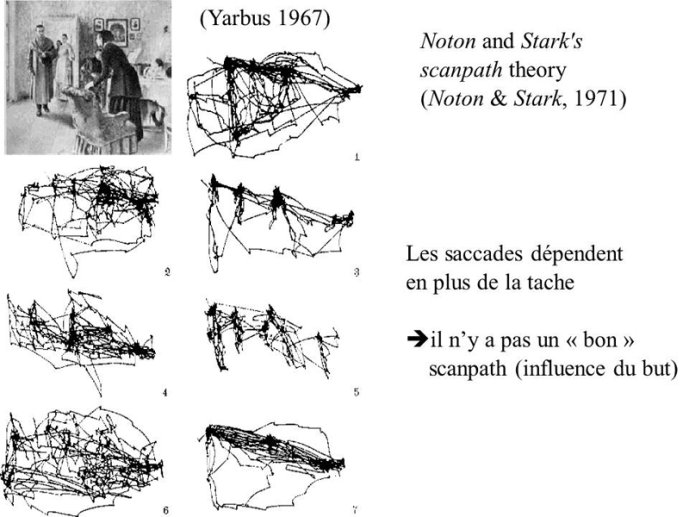

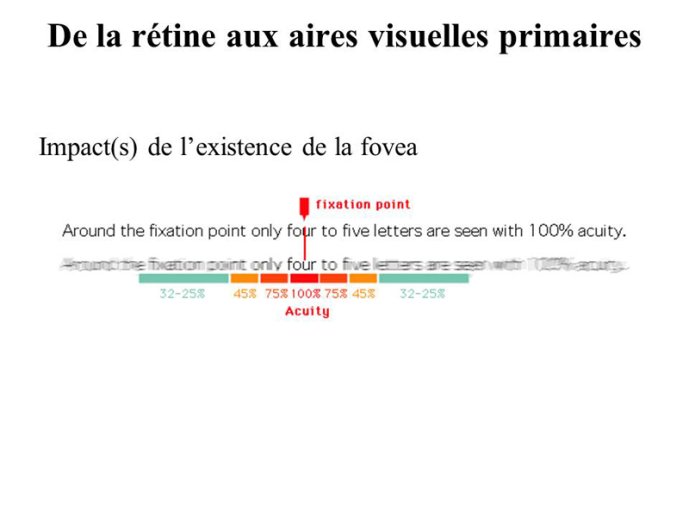

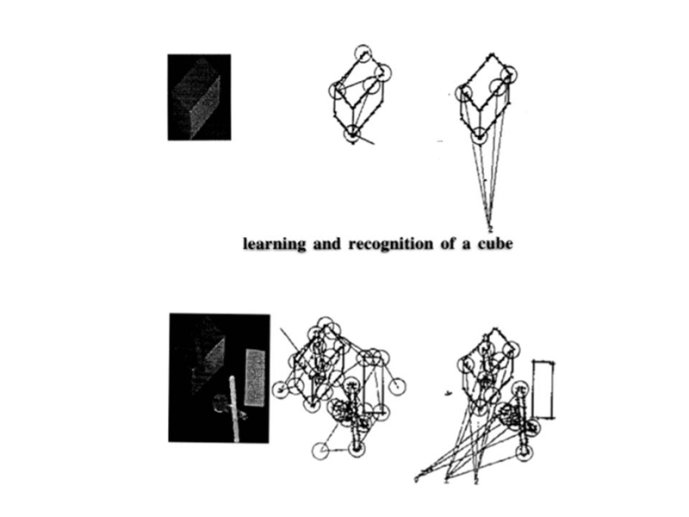

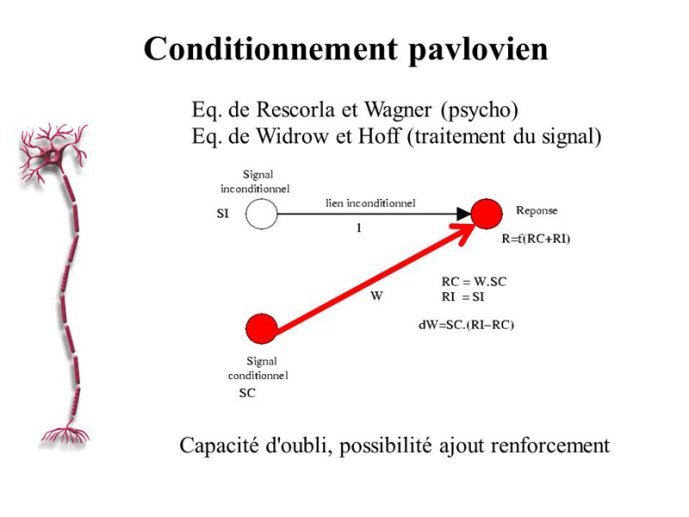

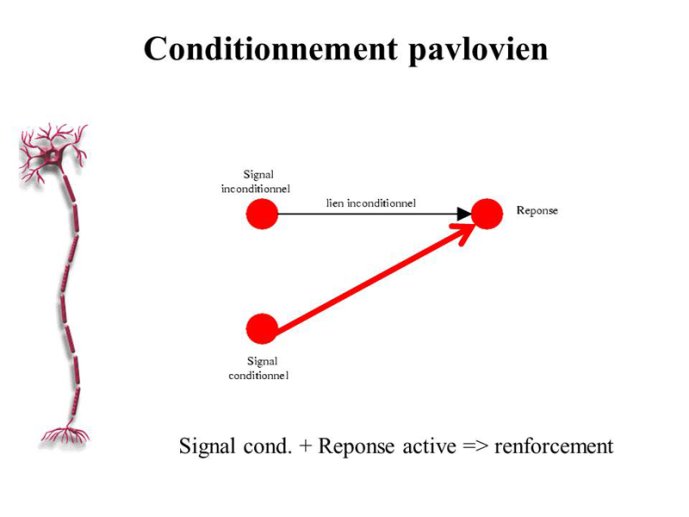

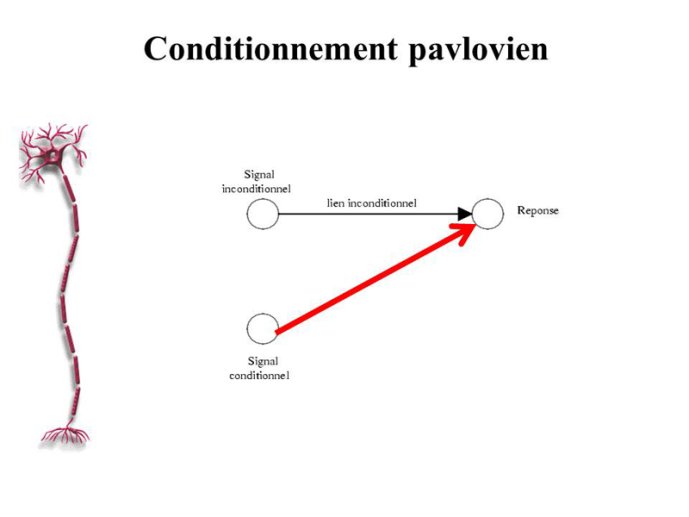

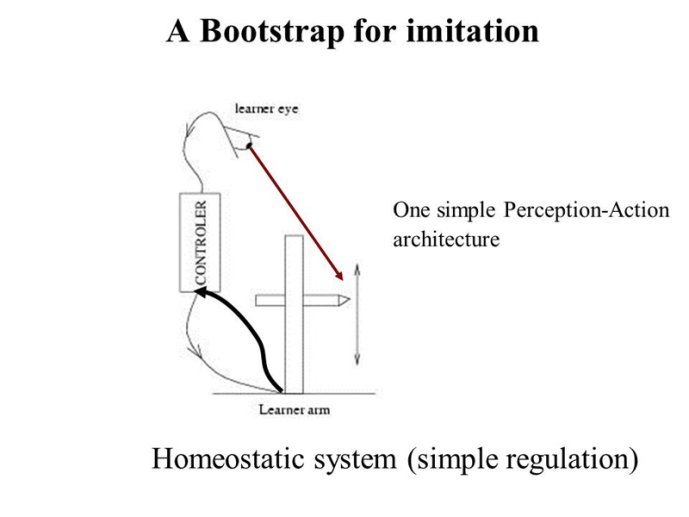

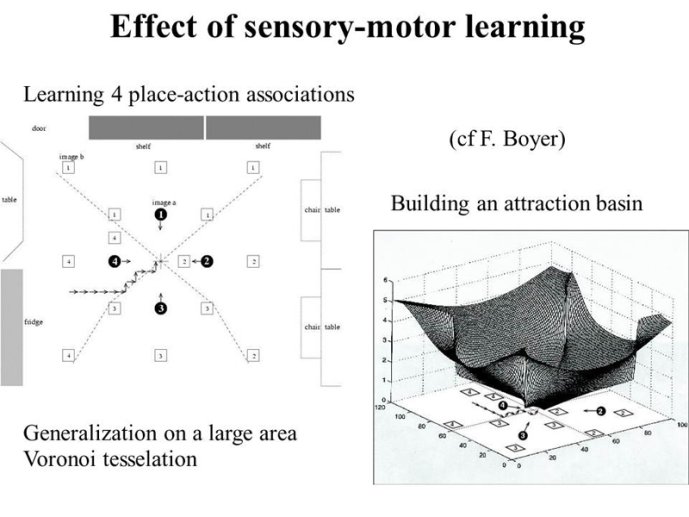

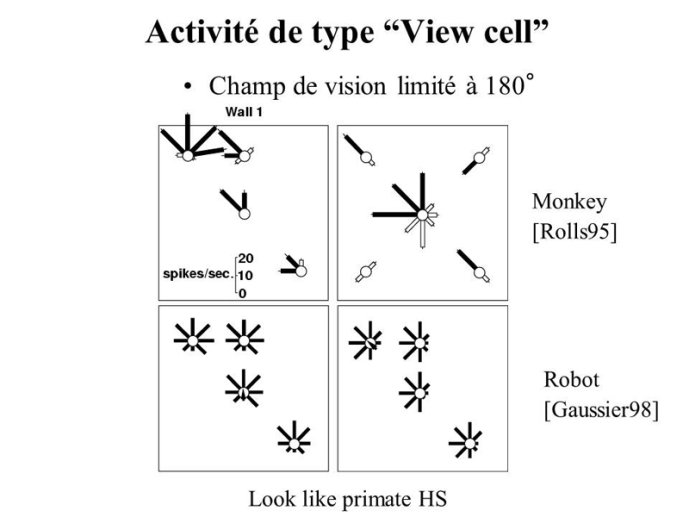

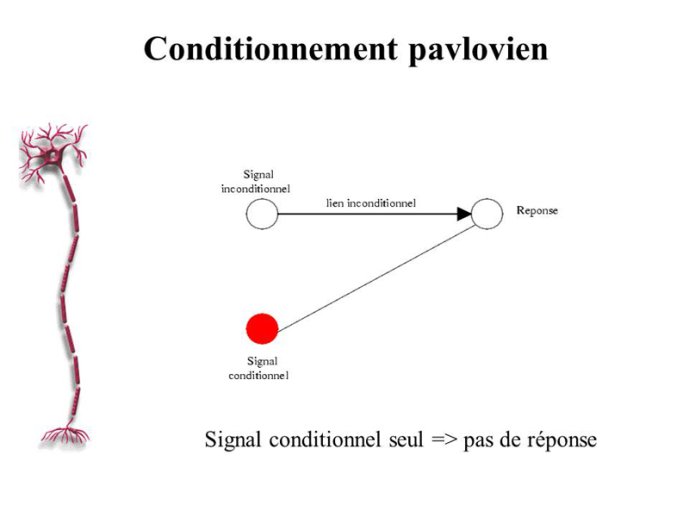

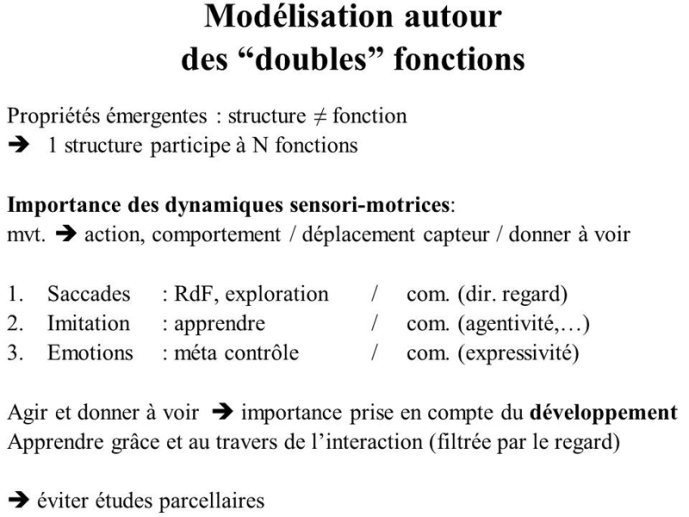

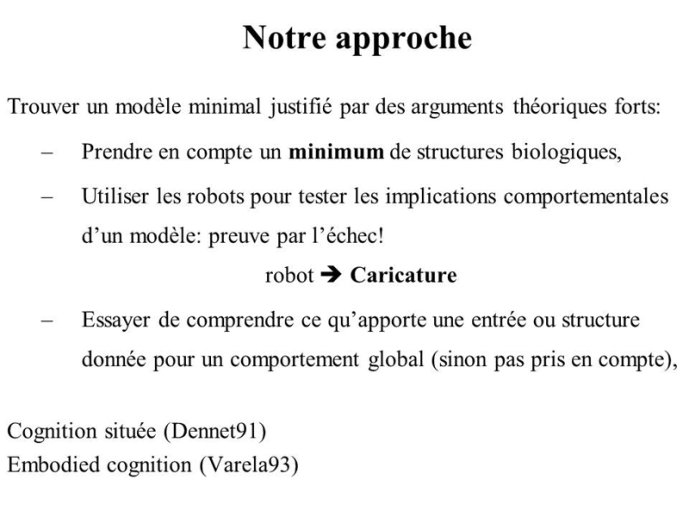

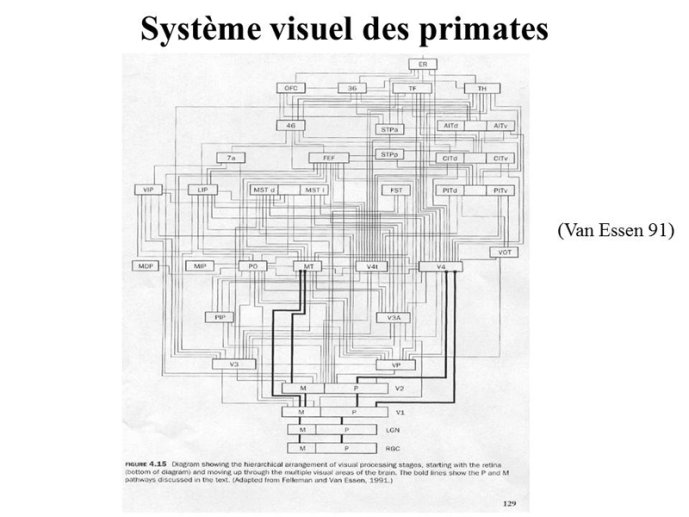

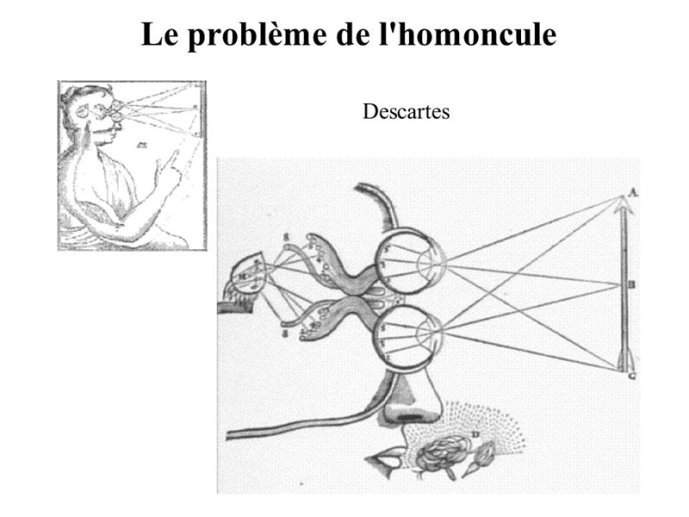

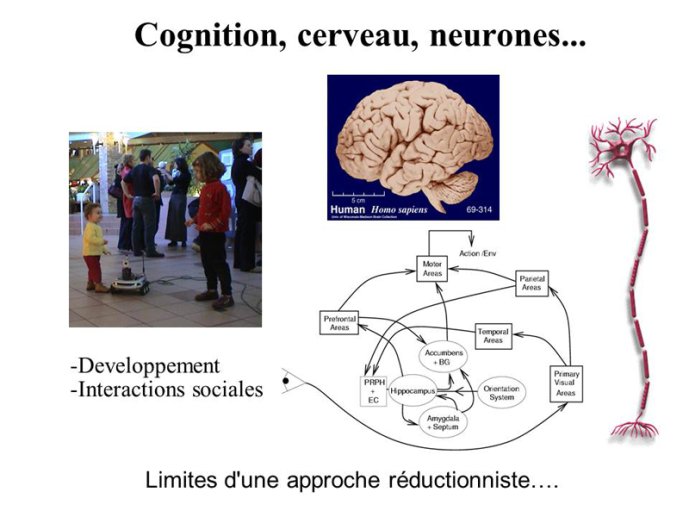

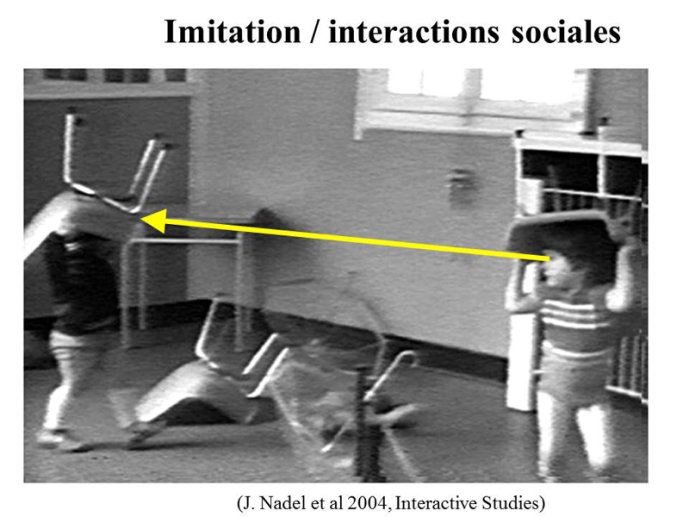

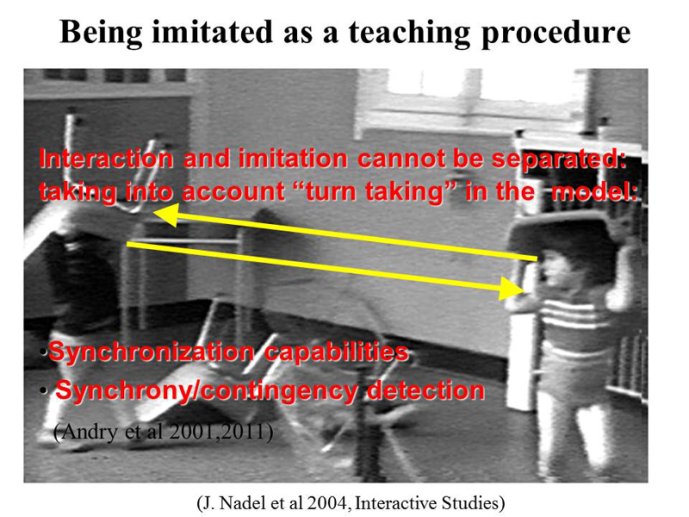

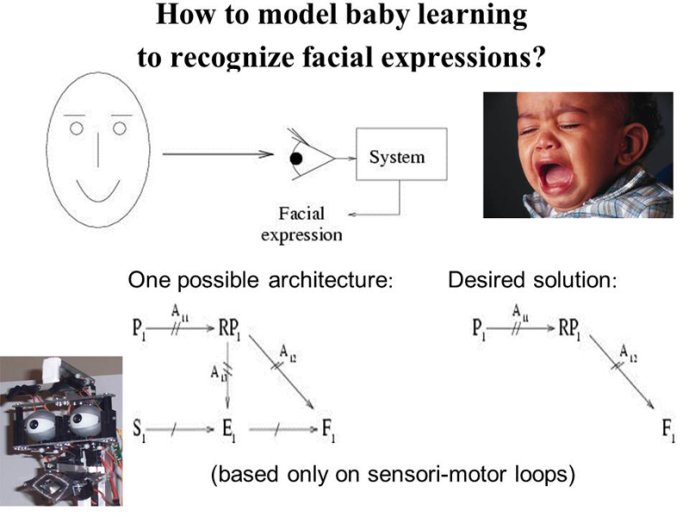

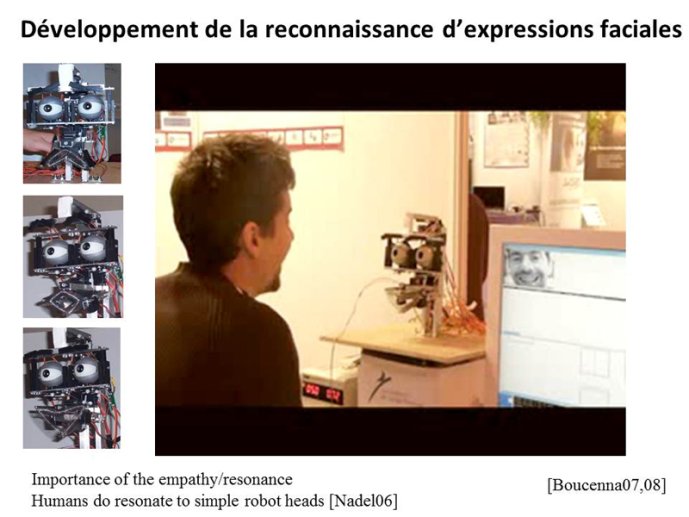

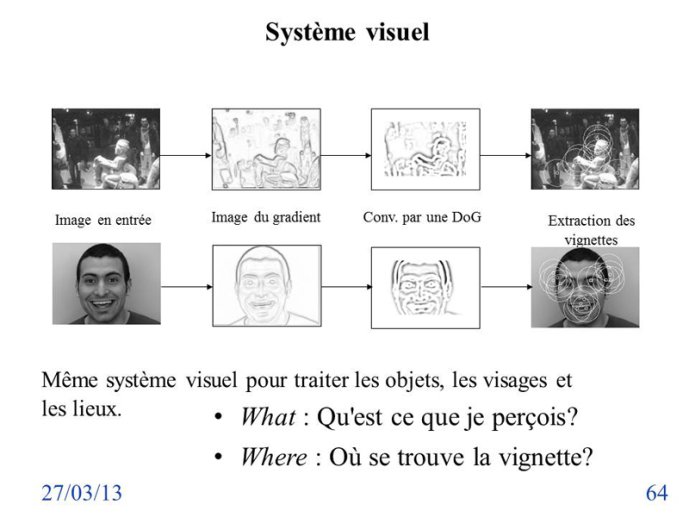

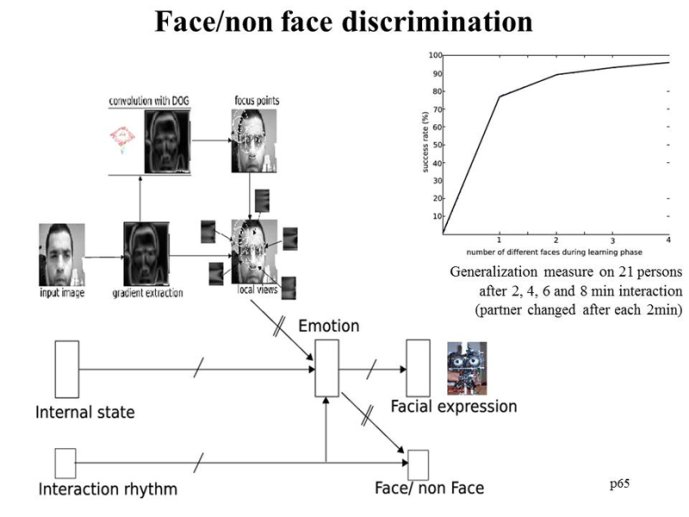

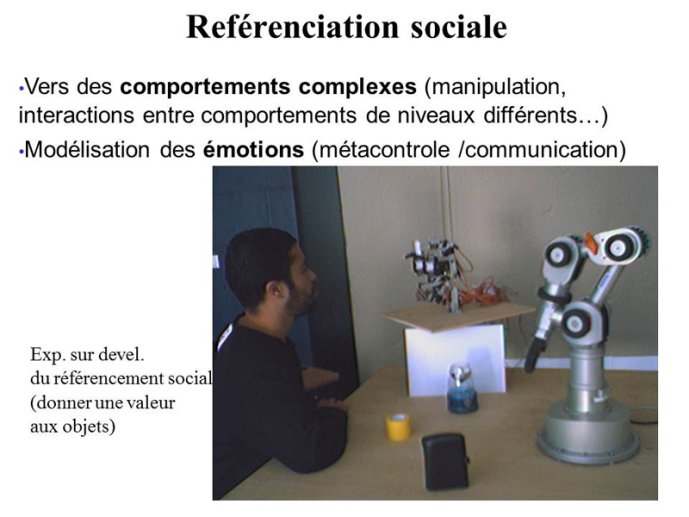

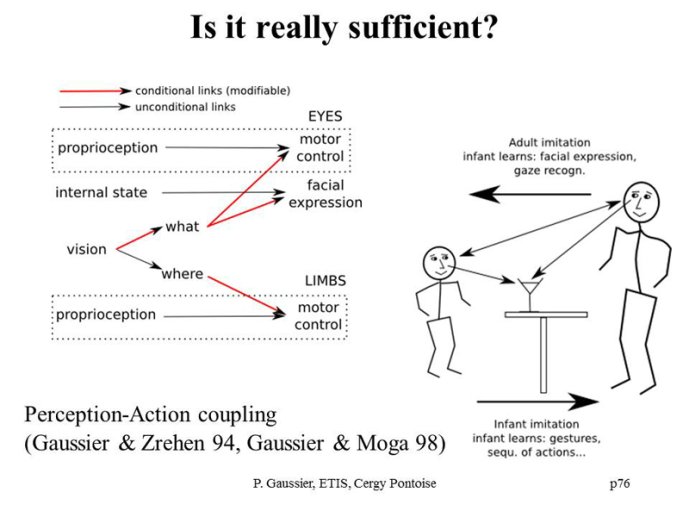

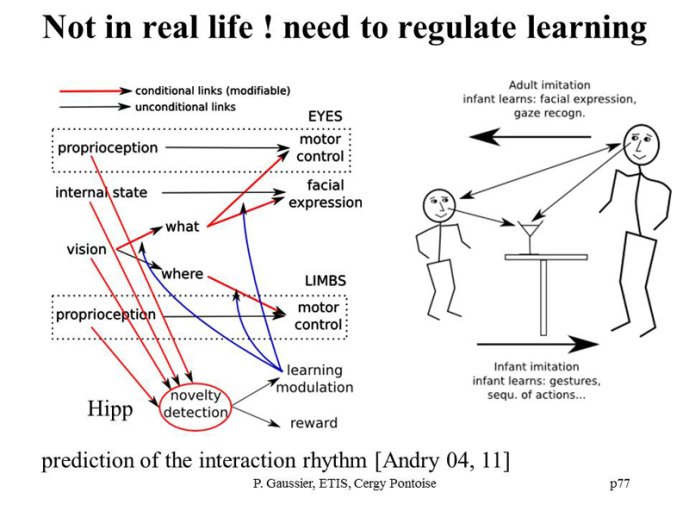

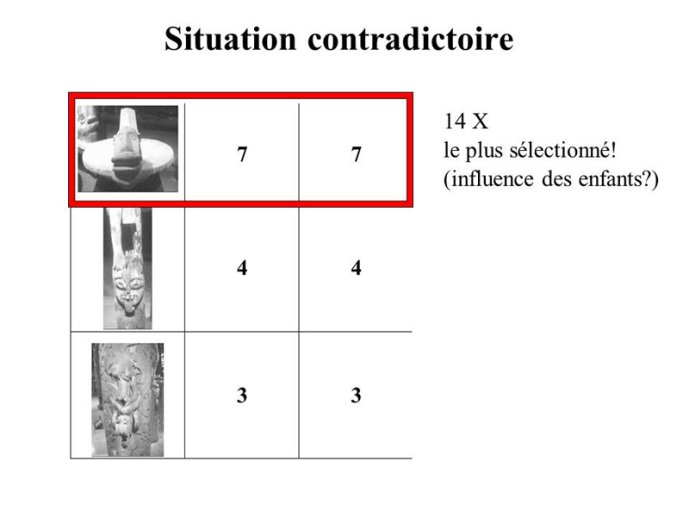

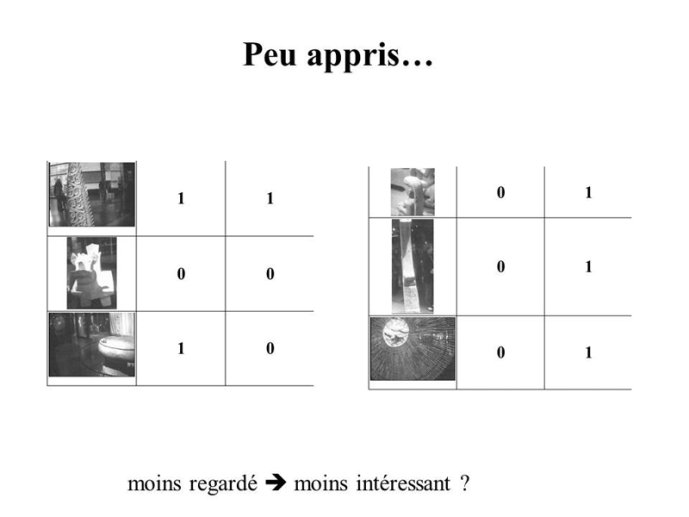

Phillippe Gaussier est professeur à l'université de cergy-Pontoise où il dirige un groupe de neurocybernétique au sein de l’UMR CNRS 8051.Ses recherches utilisent les robots comme modèles et outils pour étudier la cohérence et la dynamique de différents modèles cognitifs (approche écologique et développementale de la cognition). Elles concernent d’une part la modélisation des mécanismes cognitifs impliqués dans la perception visuelle, la navigation, la sélection de l’action et d’autre part l’étude de la dynamique des interactions entre individus.Philippe Gaussier a été membre de l’Institut Universitaire de France de 2005 à 2010.Explorer et reconnaître une scène visuelle est une question complexe que la modélisation sur ordinateur et la robotique développementale éclairent aujourd’hui d’une lumière nouvelle. Des expériences robotiques font ressortir l’intérêt d’une exploration active de la scène visuelle et de sa caractérisation en tant que séquence ou chemin entre différentes vues locales. Nous montrerons, à partir de tâches de navigation visuelle, de reconnaissance d’expressions faciales, et de préhension d’objets, comment les informations sur le « quoi » et le « où » peuvent être intégrées pour développer des systèmes robotiques robustes, mais aussi pour questionner notre compréhension des mécanismes cognitifs. Dans le cadre d’une approchedéveloppementale, nous proposons que les capacités d’imitation émergent de l’ambigüité de la perception.L’apprentissage de tâches de plus en plus complexes peut être réalisé par une architecture couplant de manière très simple les informations sensorielles aux commandes motrices, mais il faut pour cela tenir compte des interactions interindividuelles, qui peuvent grandement simplifier les problèmes.

Sur le même thème

-

Poème « Solitude », de Flora Aurima Devatine - Traduit par Marie Lamothe

Poème « Solitude », de Flora Aurima Devatine, issu de l'ouvrage Au vent de la piroguière – Tifaifai, Editions Bruno Doucey (2016). Traduction en langue des signes réalisée pour l'ouvrage Maruao, les

-

Séance conférence 2. La citoyenneté comme objectif de l'accompagnement

LabarchèdeManonAmievaHélèneSéance conférence 2 : La citoyenneté comme objectif de l'accompagnement

-

Une minute avec Lucas Joseph

JosephLucasLucas Joseph est ingénieur de recherche au sein du service Expérimentation et développement (SED) du Centre Inria de l’université de Bordeaux.

-

Les capteurs THOË et TRACESENSE

Présentation de THOË le robot sous-marin et de TRACESENSE un capteur vibrant de préconcentration

-

Présentatition Rob'Autisme

SakkaSophieSophie Sakka Directrice du GRHAPES : Présentatition Rob'Autisme

-

Une minute avec Vincent Padois

PadoisVincentVincent Padois est directeur de recherche au sein de l’équipe-projet Auctus du centre Inria de l’université de Bordeaux. Il consacre ses travaux de recherche au développement d’algorithmes de contrôle

-

« De la médecine grecque à la médecine arabe »

MicheauFrançoiseConférence de Françoise Micheau, « De la médecine grecque à la médecine arabe », mardi 6 octobre 2020.

-

Le Creativ’Lab, au cœur de la robotique et de l’intelligence artificielle (ASR N°18 - LORIA)

HénaffPatrickLefebvreSylvainLe LORIA, laboratoire phare de la Grande Région dans le domaine de l’informatique, propose de rendre la recherche plus ouverte, plus collaborative, plus ambitieuse… en un mot, plus créative, à travers

-

Comment les particularités perceptives influencent la cognition et les apprentissages ? / Isabelle …

SoulièresIsabelleLes particularités sensorielles qui accompagnent le Trouble du Spectre de l’Autisme (TSA) ont des répercussions importantes sur l’adaptation des personnes avec TSA, enfants et adultes, aux

-

Les jeudis du Grhapes 2021/2022-Handicap, Éducation et Numérique "La télé-présence mobile au servic…

La télé-présence mobile au service des enfants malades et empêchés de se rendre en classe Intervenants : Laurent Gallon et Françoise Dubergey

-

Les jeudis du Grhapes 2021/2022-Handicap, Éducation et Numérique "La télé-présence mobile au servic…

La télé-présence mobile au service des enfants malades et empêchés de se rendre en classe Intervenants : Laurent Gallon et Françoise Dubergey

-

Journée Autisme et outils numériques Les outils numériques sont-ils plus adaptés que les outils tra…

Les outils numériques sont-ils plus adaptés que les outils traditionnels pour développer les compétences adaptatives et socio-communicatives d’enfants avec TSA ? Une étude écologique et longitudinale.