Notice

« Quand une édition numérique devient-elle “critique” ? » (mars 2021)

- document 1 document 2 document 3

- niveau 1 niveau 2 niveau 3

Descriptif

Marie-Luce Demonet (Université de Tours, CESR), « Quand une édition numérique devient-elle “critique” ? »

Le site Epistemon a maintenant plus de vingt ans : quelles leçons tirer d’une expérience qui a commencé avec des transcriptions non-diplomatiques et se poursuit avec l’encodage fin des spécificités du texte, comme les différentes formes d’esperluette ? Jusqu’où aller dans la visualisation des variations (édition génétique) qui relèvent ou non de la critique textuelle ? Outre un état des lieux et une description des principes (évolutifs) qui ont guidé le développement de ce projet, l’idée est de faire le point sur quelques éditions critiques numériques actuellement disponibles, de commenter leurs choix, leur accessibilité, leur réutilisabilité par d’autres projets : bien souvent, plus l’édition est chargée d’information, moins elle est exploitable par les outils numériques et par autrui. Le renoncement à toute annotation étrangère à l’établissement du texte et à la cohérence linguistique peut décevoir, mais les formats mis à disposition, et en particulier le fichier xml/tei téléchargeable, laissent la possibilité de revenir en arrière, de simplifier autant que d’amplifier. Les questions de droits, de coût en ressources techniques et humaines — et de valorisation auprès d’un public non-universitaire — ayant un impact sur les réalisations, elles seront abordées à partir des éditions en cours de Rabelais (Cinquième livre manuscrit, vers 1560) et Montaigne (édition posthume des Essais, 1595) qui posent des problèmes d’authenticité, d’attribution et de chronologie : l’édition numérique peut tenter d’apporter des solutions.

• Projets BVH

https://bvh.hypotheses.org/projets

• Partenaires BVH

CESR (Centre d’Études Supérieures de la Renaissance)

IRHT (Institut de Recherche et d’Histoire des Textes)

• Ressources

AnaLog : outil de textométrie qui permet la lecture linéaire ou synthétique de textes annotés, les inventaires et décomptes d’unités linguistiques, leur contextualisation simultanée sur les axes paradigmatique et syntagmatique ; il est développé par Marie-Hélène Lay (Laboratoire FORELL, Université de Poitiers).

Hyperbase : logiciel d'exploration documentaire et statistique des textes ; il est diffusé par le CNRS et l'Université Nice Sophia Antipolis, conçu et développé par Étienne Brunet.

IIIF (International Image Interoperability Framework) : outil qui désigne à la fois une communauté et un ensemble de spécifications techniques, dont l’objectif est de définir un cadre d’interopérabilité pour la diffusion d’images haute résolution sur le Web.

Lucene : bibliothèque de moteur de recherche haute performance, écrite en Java.

PhiloLogic : logiciel d’interrogation des bases textuelles utilisant partiellement l’encodage TEI ; il est développé par l’Université de Chicago.

TXM : plateforme d’affichage et de traitement de données textuelles ; elle est développée par Serge Heiden (laboratoire IHRIM, équipe CACTUS, ENS Lyon).

XSLT (Extensible Stylesheet Language Transformations) : langage basé sur le XML utilisé avec des logiciels de traitements spécialisés pour la transformation de documents XML.

XTF : système de gestion et d’interrogation des métadonnées et des bases tous formats ; il est développé par l’Université de Berkeley.

Vidéo mise en ligne par Juliette Keller, métadonnées par Michela Lagnena sur UHAPOD en 2021, contenu téléversé sur Canal-U par Alicia Balasso en 2023.

Intervention / Responsable scientifique

Avec les mêmes intervenants et intervenantes

-

« La bibliothèque de Montaigne : explorer et ressentir le lieu, ouvrir et comprendre les livres » (…

DemonetMarie-LuceLegrosAlainLa reconstitution de la bibliothèque de Montaigne (le lieu, les étagères et les livres) a déjà presque dix ans : seront présentées non seulement les différentes étapes et l’historique du projet avant

Sur le même thème

-

MELPONUM : Melpomène à l'ère numérique

HugotNinaNina Hugot - enseignante-chercheuse au laboratoire Écritures (Centre lorrain de recherches interdisciplinaires dans les domaines des littératures, des cultures et de la théologie – EA 3943) de l

-

Podcast 1/4 d'heure avec : Nina Hugot, enseignante-chercheuse du laboratoire Écritures de l'Univers…

HugotNinaRencontre avec Nina Hugot - enseignante-chercheuse du laboratoire Écritures (Centre lorrain de recherches interdisciplinaires dans les domaines des littératures, des cultures et de la théologie – EA

-

Causeries Culture - Humanités Numériques, Intelligence Artificielle, littérature et technologies #6

PorlierChristopheBertaniNicolaCauseries Culture - Humanités Numériques, Intelligence Artificielle, littérature et technologies #6

-

Faire une histoire des territoires en contexte montagneux : l’organisation de l’espace par les fonc…

SuméraPaula[séminaire] Faire une histoire des territoires en contexte montagneux : l’organisation de l’espace par les fonctionnaires natifs (tusi 土司) dans la région des monts Wuling (Chine impériale tardive,

-

Retour sur la journée Traits d'union du 19/09/2025 "écrire, transcrire pour la société"

BergèreMarcFrangnePierre-HenryGuillotAgatheQuéréAnnaRuelleCharlesSchuweyChristopheQuelles formes, quelles médiations, quels intermédiaires permettent aux chercheuses et chercheurs en arts, lettres, langues, sciences humaines et sociales de tracer des traits d'union entre recherche

-

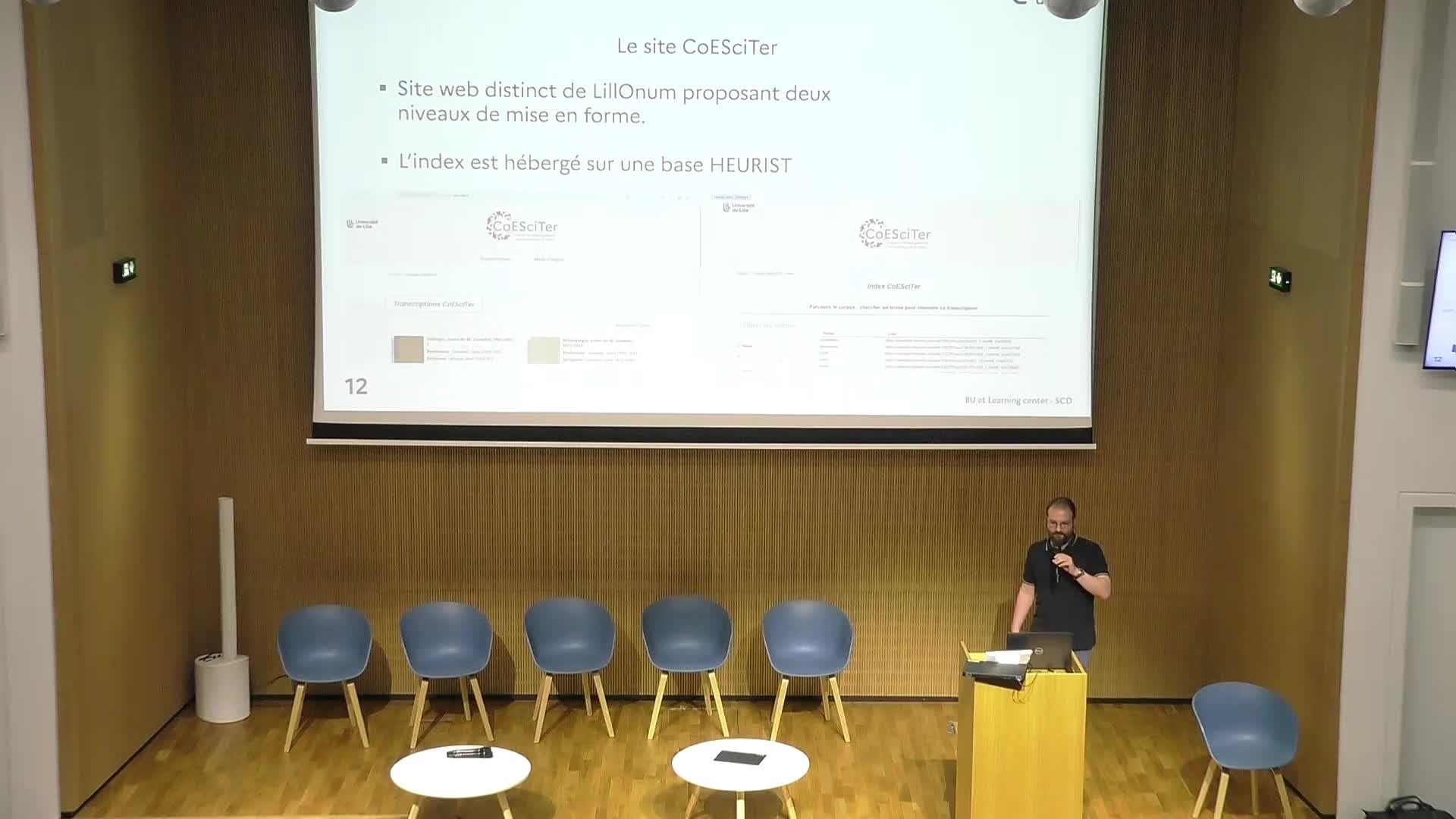

Projet CoESciTER

HarauxGeoffreyPrésentation du projet CoESciTER – Corpus Enseignement des Sciences de la Terre.

-

Digital Benin: a digital platform connecting the displaced royal artefacts from Benin Kingdom

Digital Benin: a digital platform connecting the displaced royal artefacts from Benin Kingdom

-

Multilinguality and data access: an area studies librarian’s perspective

WagnerCosimaMultilinguality and data access: an area studies librarian’s perspective

-

InVisto : Base de données pour l’histoire du livre et de l’édition vietnamienne en Cochinchine (18…

CaoThúy VyL’histoire du livre et de l’édition vietnamienne en Cochinchine (1890-1945)

-

Comment s’orienter dans la forêt des ressources et des outils numériques ?

BurriInèsAntiqui.TXTes - Sciences des textes anciens

-

Base de données et cartographie. Pour une nouvelle approche des monastères latins dans les États la…

ArtaudFlorianÀ travers son projet doctoral, Florian Artaud propose une relecture des institutions monastiques latines dans les États latins d’Orient, en les abordant sous l’angle de la territorialité. Au cœur de

-

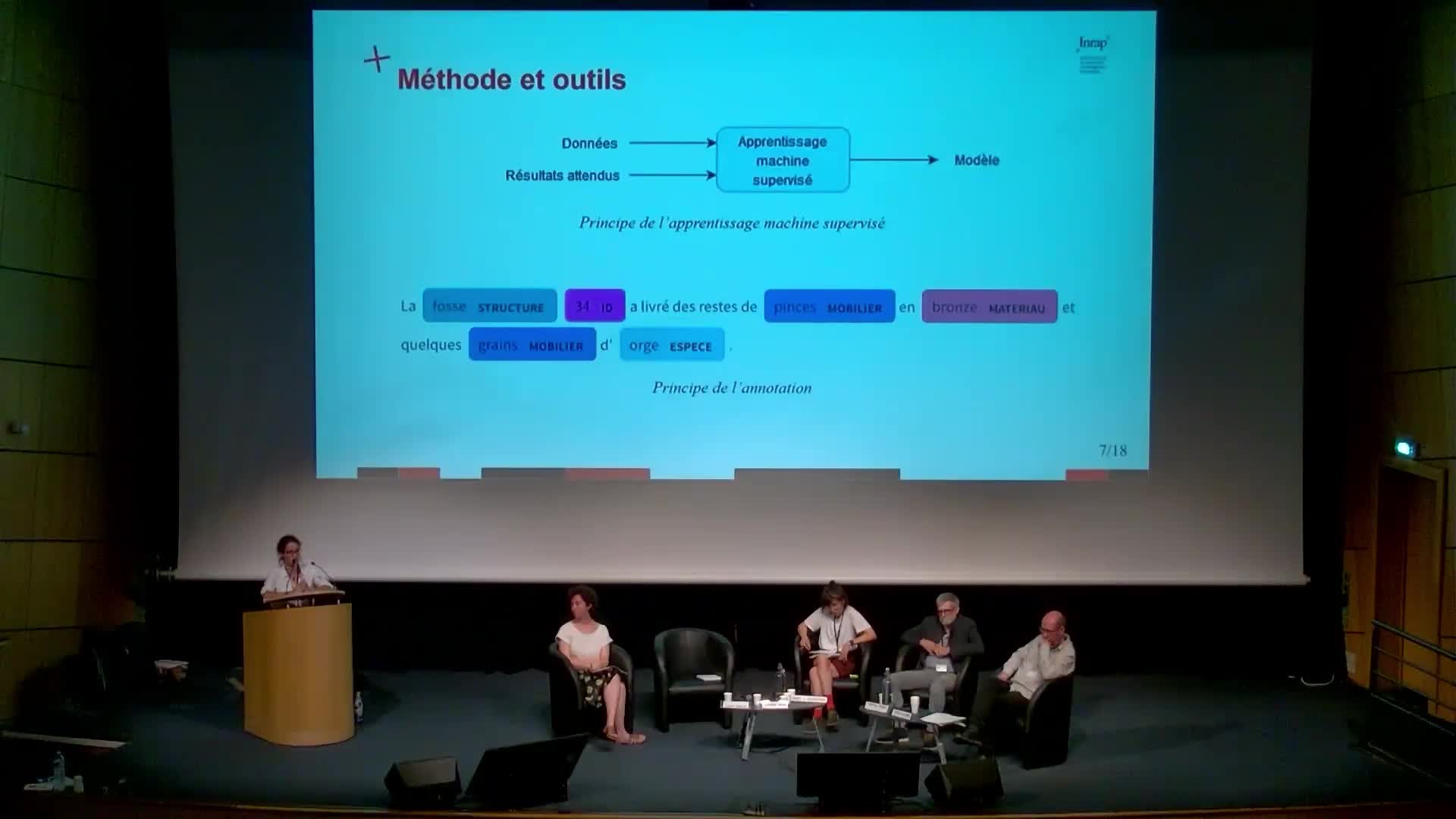

L'IA comme aide à la recherche : l'expérimentation du traitement automatique des langues appliqué a…

MenuArianeAriane Menu (direction scientifique et technique, Inrap) présente ici un exemple d'utilisation du traitement automatique des langues pour repérer des mots-clés dans un corpus de texte et montre